机器之心报道

编辑:陈陈

在 Agentic AI 时代,模型不再是独来独往的学霸,而是开始学会组队、一起想问题。多智能体系统(MAS,multi-agent systems)的发展让 AI 世界从一个人苦想变成了多人头脑风暴。尤其是基于大语言模型的 MAS,如今已经被用在各种任务中。

不过,在这个组合里,AI 基本靠文本交流,最近有人开始思考:LLM 在大脑里(也就是潜在空间)想事情时,其实比说出来要丰富得多。

于是一些研究开始尝试让模型直接用隐藏层来表示想法,比如 (i) 用 Transformer 的隐藏表示来实现单模型的潜在链式思考推理, (ii) 使用 KV 缓存或层级嵌入在两个模型之间交换信息。

然而,一个能够同时统一潜在推理与潜在通信的全面模型协作框架仍未被探索出来。

为进一步推进这一方向,来自普林斯顿大学等机构的研究者提出:MAS 能否实现真正的纯潜在空间协作?

为回答这一问题,他们提出一种多智能体推理框架 LatentMAS,其将智能体之间的协作从传统的 token 空间转移到了模型的潜在空间。核心创新是:让所有智能体不再通过文本交流,而是在潜在空间中直接协作。

一直以来,传统 MAS 依赖自然语言沟通,各个 LLM 之间用文本交流思路。这种方法虽然可解释,但冗长、低效、信息易丢失。LatentMAS 则让智能体直接交换内部的隐藏层表示与 KV-cache 工作记忆,做到了:

高效的多步推理:在大幅减少 token 的情况下,实现更复杂的思考过程; 无需训练的潜在空间对齐机制,确保生成过程稳定可靠; 通用性强:可兼容任意 HuggingFace 模型,并可选择性地支持 vLLM 后端。总体而言,LatentMAS 在多智能体系统中实现了更高的性能、更低的 token 使用量,以及显著的实际运行速度提升。

为了实证评估 LatentMAS 的有效性,本文在九个基准任务上进行了全面实验,这些任务涵盖数学与科学推理、常识理解和代码生成。

结果显示 LatentMAS 始终优于强大的单模型和基于文本的 MAS 基线:(i) 准确率最高提升 14.6%,(ii) 输出 token 使用量减少 70.8%-83.7%,(iii) 端到端推理速度加快 4×-4.3×。这些结果表明,潜在协作不仅提升了系统级推理质量,还在无需额外训练的情况下带来了显著的效率收益。

论文标题:Latent Collaboration in Multi-Agent Systems

论文地址:https://arxiv.org/pdf/2511.20639

GitHub 地址:https://github.com/Gen-Verse/LatentMAS

论文标题:Latent Collaboration in Multi-Agent Systems

论文地址:https://arxiv.org/pdf/2511.20639

GitHub 地址:https://github.com/Gen-Verse/LatentMAS 这篇文章也得到了很多人转发评论,可供大家参考。比如这位网友的观点很好的概括论文:

「在传统的多智能体系统中,我们通常让智能体 A 生成文本,再由智能体 B 读取并处理。这种文本瓶颈既浪费算力,又严重稀释语义信息。LatentMAS 带来了一种近乎心灵感应式的替代方案:智能体通过交换潜在思维来协作。

智能体 A 不再把推理结果解码成文本,而是将它的工作记忆,也就是注意力层中的 KV 缓存直接传给智能体 B。于是智能体 B 在启动时,仿佛已经加载了 A 的全部推理过程。

通过将第一个智能体生成的 KV 对直接注入第二个智能体的注意力机制中,第二个智能体会把前者的内部状态当作自己的提示,从而完全绕过离散的 token 化层。这种方法比基于文本的协作快 4.3 倍,并减少 80% 以上的 token 使用量。更重要的是,它无需昂贵的训练,只用简单的线性对齐就能让嵌入空间兼容。

智能体 A 的潜在思维被直接复制进智能体 B 的记忆之中。」

还有人认为这会终结基于文本的 AI:

方法介绍

LatentMAS 是一个端到端的潜在协作框架:当给定一个输入问题时,所有智能体的推理与交流都完全在潜在空间中进行,只有最终答案才会被解码为文本输出。其核心设计结合了智能体的内部潜在思维生成与跨智能体潜在工作记忆传递。

在每个智能体内部,推理通过自回归地生成最后一层隐藏表示来展开,从而无需显式解码即可捕捉模型持续进行的内部思考; 在智能体之间,信息通过存储在各层 KV 缓存中的共享潜在工作记忆进行交换,其中包含输入上下文以及新生成的潜在思维内容。基于这些设计,LatentMAS 建立在三个基本原则之上,这些原则也通过全面的理论与实验分析得到了验证:

推理表达能力:隐藏表示天然地编码模型的连续思维,使得每一步潜在推理都能传递远比离散 token 更丰富的信息。 通信保真度:潜在工作记忆完整保留了每个模型的输入表示与潜在思维,从而实现跨智能体的无损信息传递。 协作复杂度:与 TextMAS 相比,LatentMAS 在协作表达能力更强的同时,其推理复杂度却显著更低。前两个原则共同强调了 LatentMAS 的核心优势:它能够支持更丰富的潜在推理,并实现无损的潜在交流。第三个原则则从整体复杂度角度进一步说明:LatentMAS 在保持高表达能力的前提下,其计算复杂度远低于基于文本的 MAS。

该方法使系统中的 LLM 智能体能够:

(i)在潜在空间中生成具有超强表达能力的潜在思维;

(ii)在智能体交互过程中,以无损的方式保留并传递各自的潜在工作记忆;

(iii)在保持与传统 TextMAS 相同表达能力的同时,实现显著更低的计算复杂度。

实验

本文在九个基准上对 LatentMAS 进行了全面评估,这些基准覆盖通用任务与高强度推理任务两大类。

在模型上,本文采用 Qwen3 系列的三个模型:4B、8B 和 14B,用于构建不同规模的 LatentMAS。所有实验均在 8× NVIDIA A100-80G GPU 上完成。

表 1、表 2 和表 3 展示了 LatentMAS 整体表现。他们从三个互补维度进行评估:(i) 任务准确率、(ii) 系统吞吐量(总输出 token 数)、(iii) 端到端推理速度。

结果显示,在所有任务上,LatentMAS 相比单模型基线在顺序式与层级式 MAS 设置下分别平均提升 14.6% 和 13.3% 的准确率;相比文本式 MAS,在两种设置下分别额外提升 2.8% 与 4.6%。

在相同 MAS 架构下,LatentMAS 相比顺序式与层级式 TextMAS 平均分别实现 4× 与 4.3× 的推理加速。

此外,由于整个协作过程完全发生在潜在空间中,LatentMAS 相比 TextMAS 在顺序式与层级式设置下分别减少 70.8% 与 83.7% 的 token 使用量。

高效率潜在协作

LatentMAS 在理论上可实现远高于 TextMAS 的效率。本文进一步通过实证对 LatentMAS 与 TextMAS 的效率进行了验证。正如图 1 和图 4(左)所示,即使在 TextMAS 基线已经通过 vLLM 服务加速后,LatentMAS 依然能提供 2.6×–7× 的额外加速。

这种显著提升来源于:latent 推理只需较少的 latent steps,而文本推理则需要大量的 per-token 解码步骤。例如:在不到 50 个 latent steps 的情况下,LatentMAS 就能在像 AIME 24/25 这样高强度推理任务中达到甚至超过文本 MAS 的表现;而文本 MAS 通常需要超过 2 万个输出 token 来完成完整的文本 CoT 推理轨迹。

此外,如图 1 和图 4(右)所示,LatentMAS 相比 TextMAS 可减少 59.4%–87.9% 的 token 使用量,因为 LatentMAS 中的智能体通过将潜在工作记忆直接注入其他智能体的内部层来交流,而非依赖文本中转。

值得注意的是,LatentMAS 相比单模型推理仍能减少 15.0%–60.3% 的 token 使用量。这是因为,在 LatentMAS 中,输入问题由多个协作智能体分担,使得最终的智能体只需汇总前序的潜在思维并生成最终答案,因此所需输出文本显著减少。

最终,整个系统在使用更少 output tokens 的同时,反而获得了更高的准确率。

深入分析 LatentMAS

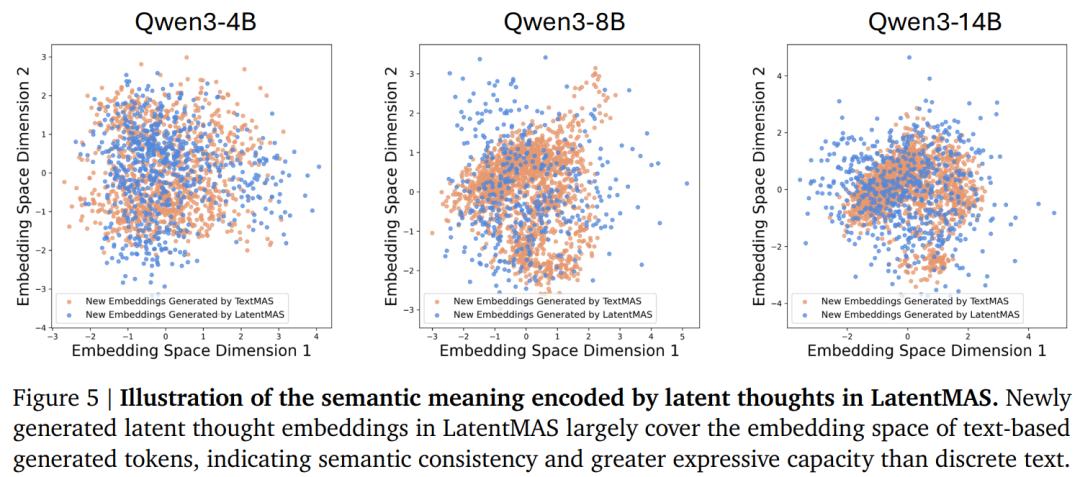

在这一部分,本文首先验证 LatentMAS 生成的潜在思维是否具有有意义且语义丰富的表达。为此,本文比较了 LatentMAS 新生成的最后一层隐藏向量与 TextMAS 逐 token 生成的响应嵌入分布。如图 5 所示:

LatentMAS 的最后一层嵌入与 TextMAS 的 token 嵌入分布区域几乎重叠,说明潜在思维编码的语义与对应的文本响应一致。 LatentMAS 的隐藏嵌入分布覆盖范围比 TextMAS 更广,表明潜在思维比离散 token 拥有更高的多样性和表达能力。这些结果共同说明:潜在思维不仅能够捕捉对应文本的有效语义,还蕴含更丰富、更具表现力的内部表示。

为了确定 LatentMAS 的最佳 latent step 数量,本文在三个下游任务中逐步增加 latent step ,以观察深度影响。如图 8 所示,随着 latent steps 增加,下游性能普遍提升,说明额外的潜在思维提高了 AI 协作表达能力。