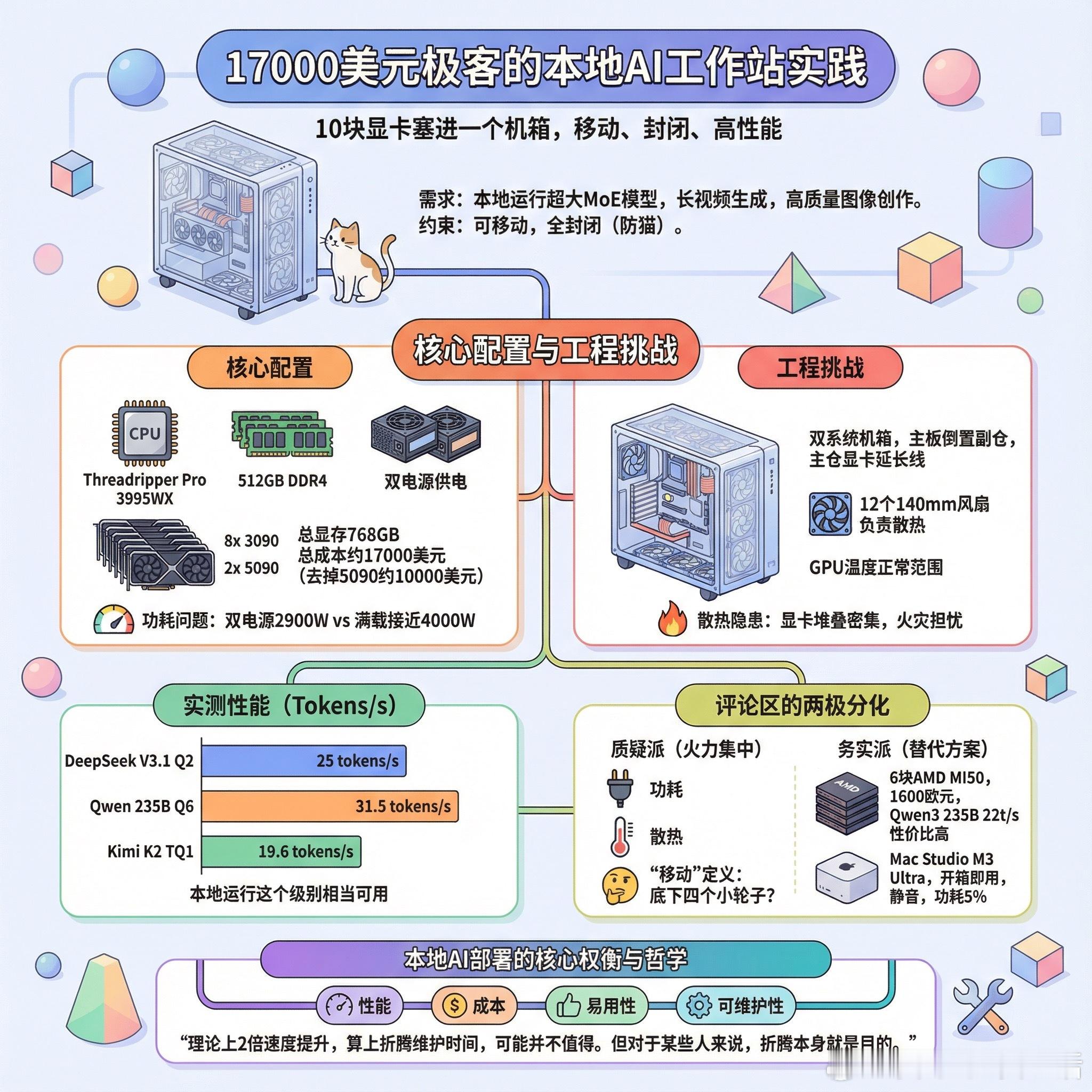

【17000美元,10块显卡塞进一个机箱:一位极客的本地AI工作站实践】当云端算力唾手可得,为什么还有人执着于在家里堆砌显卡?Reddit用户SweetHomeAbalama0给出了一个答案:一台塞进8块3090和2块5090、总显存768GB的“移动”AI工作站。这台机器的诞生源于一个实际需求:为一位平面设计师提供本地运行超大MoE模型的能力,同时支持长视频生成和高质量图像创作。约束条件很有意思:必须可移动,必须封闭。后者的原因让人会心一笑:家里有好几只猫。核心配置包括Threadripper Pro 3995WX处理器、512GB DDR4内存、256GB显存,双电源供电。总成本约17000美元,如果去掉两块5090,成本可以压到10000美元左右。最大的工程挑战是如何把10块显卡塞进一个封闭机箱。矿机架加滚轮的方案首先被否决,不仅丑,而且结构强度存疑。最终选择了Thermaltake Core W200,这是一款双系统机箱,将主板倒置安装在副仓,主仓用来安装显卡和延长线。12个140mm风扇负责散热,GPU温度在负载下保持在正常范围。实测性能:DeepSeek V3.1 Q2量化版约25 tokens每秒,Qwen 235B Q6量化版约31.5 tokens每秒,Kimi K2 TQ1约19.6 tokens每秒。对于本地运行这个级别的模型来说,这个速度相当可用。评论区的反应两极分化。质疑派的火力集中在几个点:功耗问题,10块显卡满载功耗接近4000W,而双电源总额定功率只有2900W;散热问题,从照片看显卡堆叠密集,有人直言这是“火灾隐患”;还有那个“移动”的定义,有人调侃“移动是因为底下有四个小轮子吗”。务实派则提出了替代方案。一位用户分享了自己用6块AMD MI50搭建的系统,总成本约1600欧元,运行Qwen3 235B Q4量化版可以达到22 tokens每秒,性价比惊人。另一位用户建议直接买Mac Studio M3 Ultra 512GB版本,虽然性能稍逊,但开箱即用、完全静音、功耗只有这台机器的5%。这场讨论触及了本地AI部署的核心权衡:性能、成本、易用性、可维护性。云端方案省心但有隐私顾虑和持续成本;消费级显卡堆叠性价比高但工程复杂度爆炸;专业级方案如Mac Studio或AMD MI系列各有取舍。有一条评论说得精辟:理论上2倍的速度提升,在你算上折腾、调试、维护、诊断各种奇怪错误的时间后,可能并不值得。但对于某些人来说,折腾本身就是目的。reddit.com/r/LocalLLaMA/comments/1qi4uj2/768gb_fully_enclosed_10x_gpu_mobile_ai_build