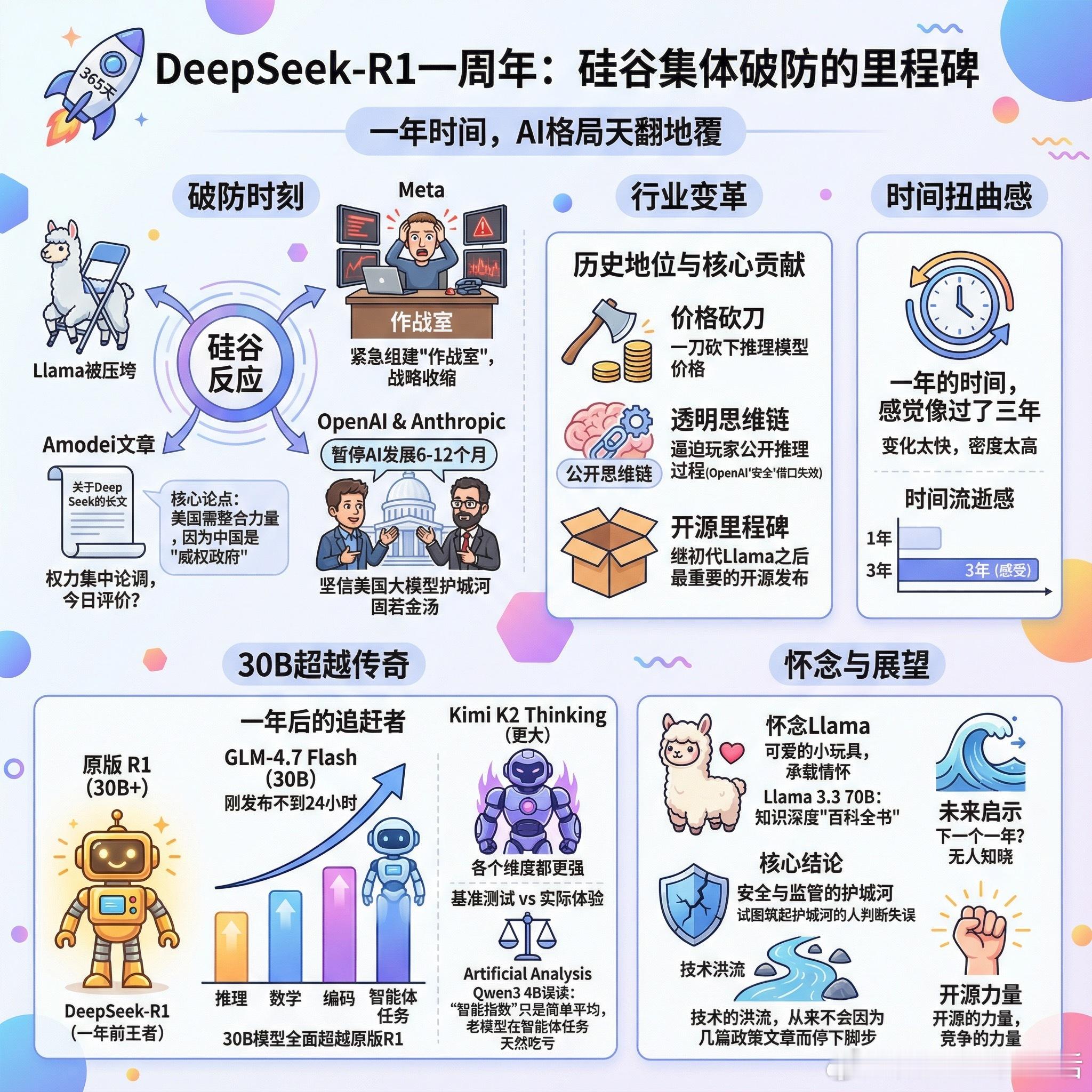

【DeepSeek-R1一周年:那个让硅谷集体破防的模型】一年前的今天,DeepSeek-R1横空出世。仅仅365天,整个AI格局已经天翻地覆。这个模型当时造成的冲击,现在回看依然令人咋舌。扎克伯格被迫解散Meta旗舰AI训练团队,紧急组建"作战室",最终选择战略收缩。Llama像折叠椅一样被压垮。更讽刺的是,Altman和Dario当时还在国会游说,要求暂停AI发展6到12个月,他们坚信美国大模型的护城河固若金汤。Amodei那篇关于DeepSeek的长文现在读来别有滋味。他当时的核心论点是:美国需要整合力量,因为中国是"威权政府"。言下之意,权力集中在美国手里才是"民主之举"。这个论调放到今天,不知该作何评价。R1的历史地位毋庸置疑:它一刀砍下了推理模型的价格,逼迫所有玩家公开推理过程。还记得OpenAI以"安全"为由隐藏思维链吗?有了竞争对手,态度立刻软化。如果我为思考过程付费,我就应该看到完整的思考过程,这本是天经地义的事。有人说,这是继初代Llama之后最重要的开源发布。一年的时间,感觉像过了三年。这种时间扭曲感本身就说明了一切:变化太快,密度太高。那么问题来了:一年后的今天,需要多大的模型才能追平当初的R1?答案让人感慨。刚发布不到24小时的GLM-4.7 Flash,一个30B的模型,在推理、数学、编码、智能体任务上已经全面超越原版R1。如果看更大的模型,Kimi K2 Thinking在各个维度都更强。当然,基准测试和实际体验是两回事。有人指出Artificial Analysis上Qwen3 4B能匹配R1,但这是对该平台的误读。那个"智能指数"只是12个基准的简单平均,老模型在智能体任务上天然吃亏,因为当时根本没人针对这些场景训练。也有人怀念Llama。不是因为它最强,而是因为它像一个可爱的小玩具,承载着某种情怀。Llama 3.3 70B在知识深度上仍然是同尺寸最强的"百科全书"。一年时间,从"不可能"到"稀松平常"。30B模型超越曾经的王者,这就是开源的力量,也是竞争的力量。下一个一年会发生什么?没人知道。但有一点可以确定:那些试图用"安全"和"监管"筑起护城河的人,已经被证明判断失误。技术的洪流,从来不会因为几篇政策文章而停下脚步。reddit.com/r/LocalLLaMA/comments/1qhs2sd/its_been_one_year_since_the_release_of_deepseekr1