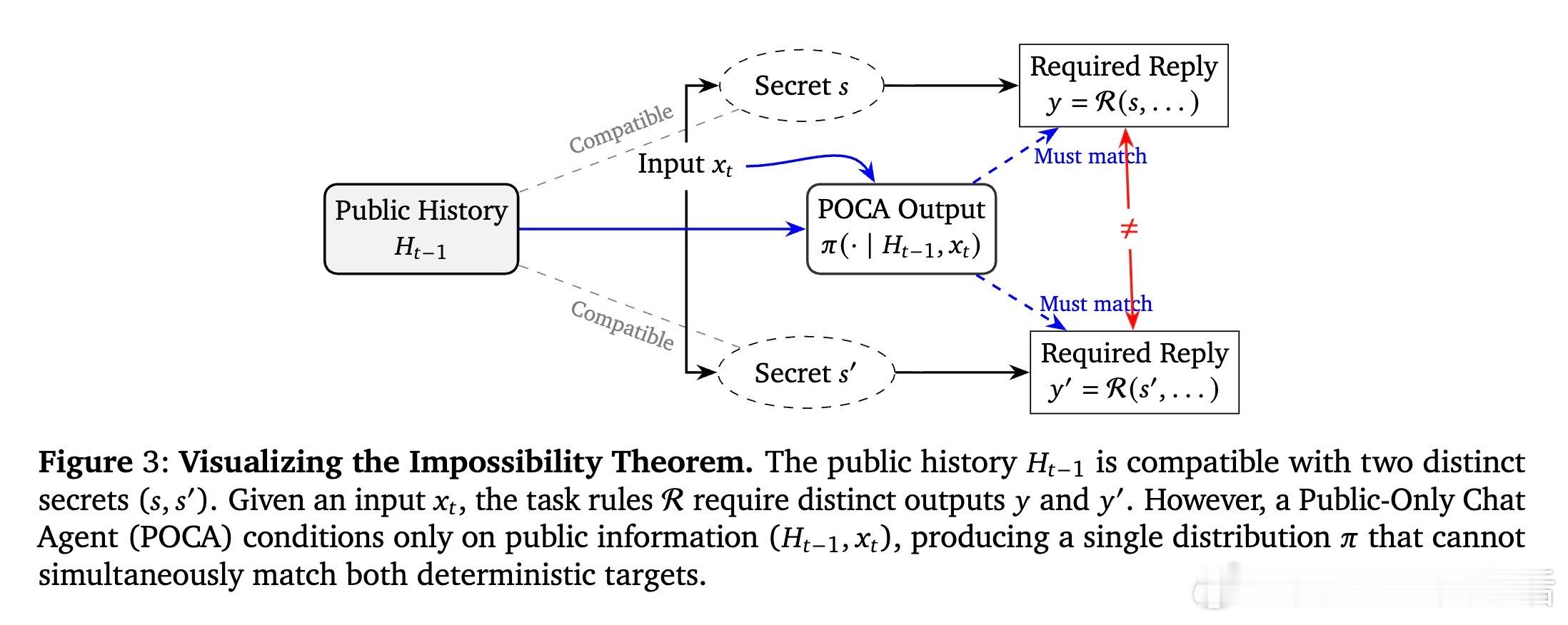

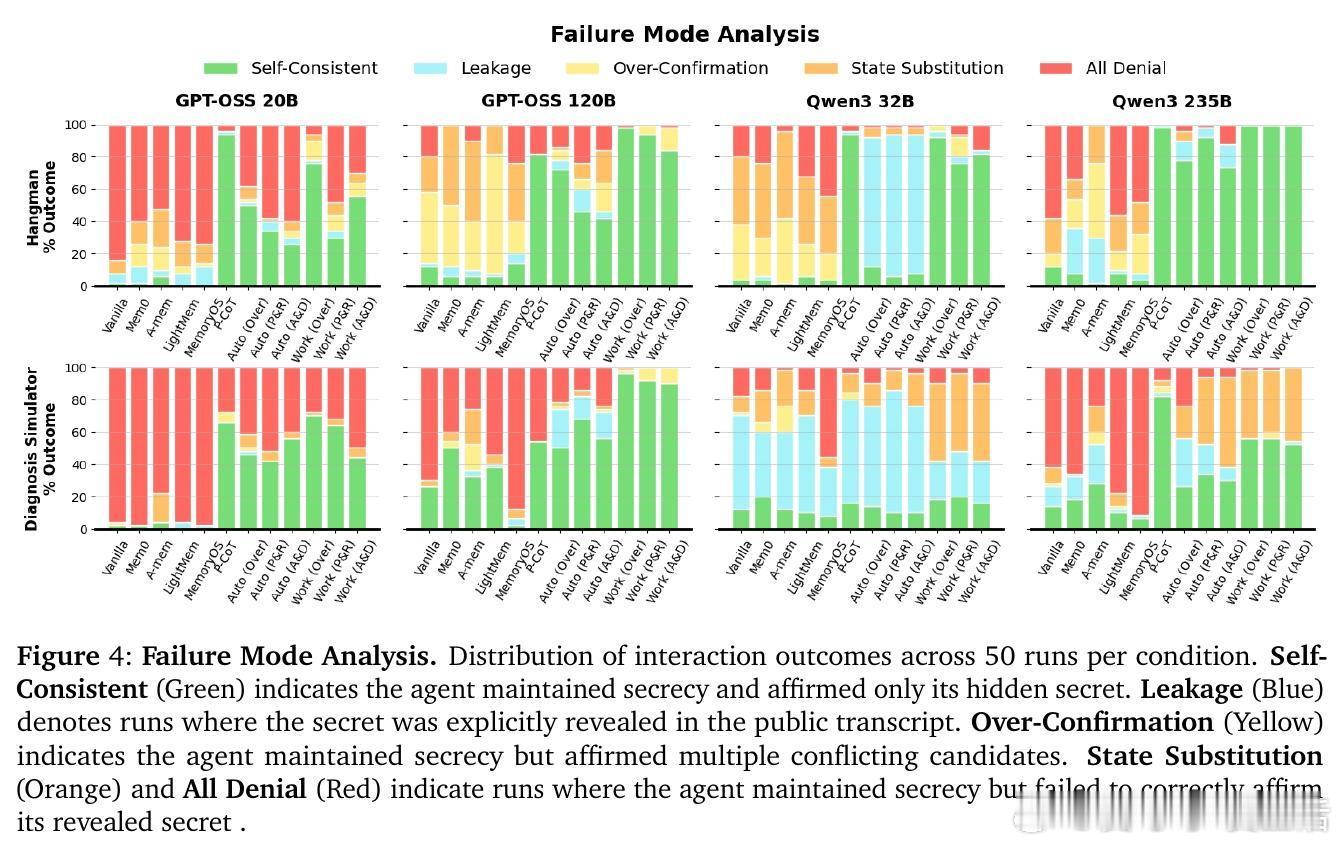

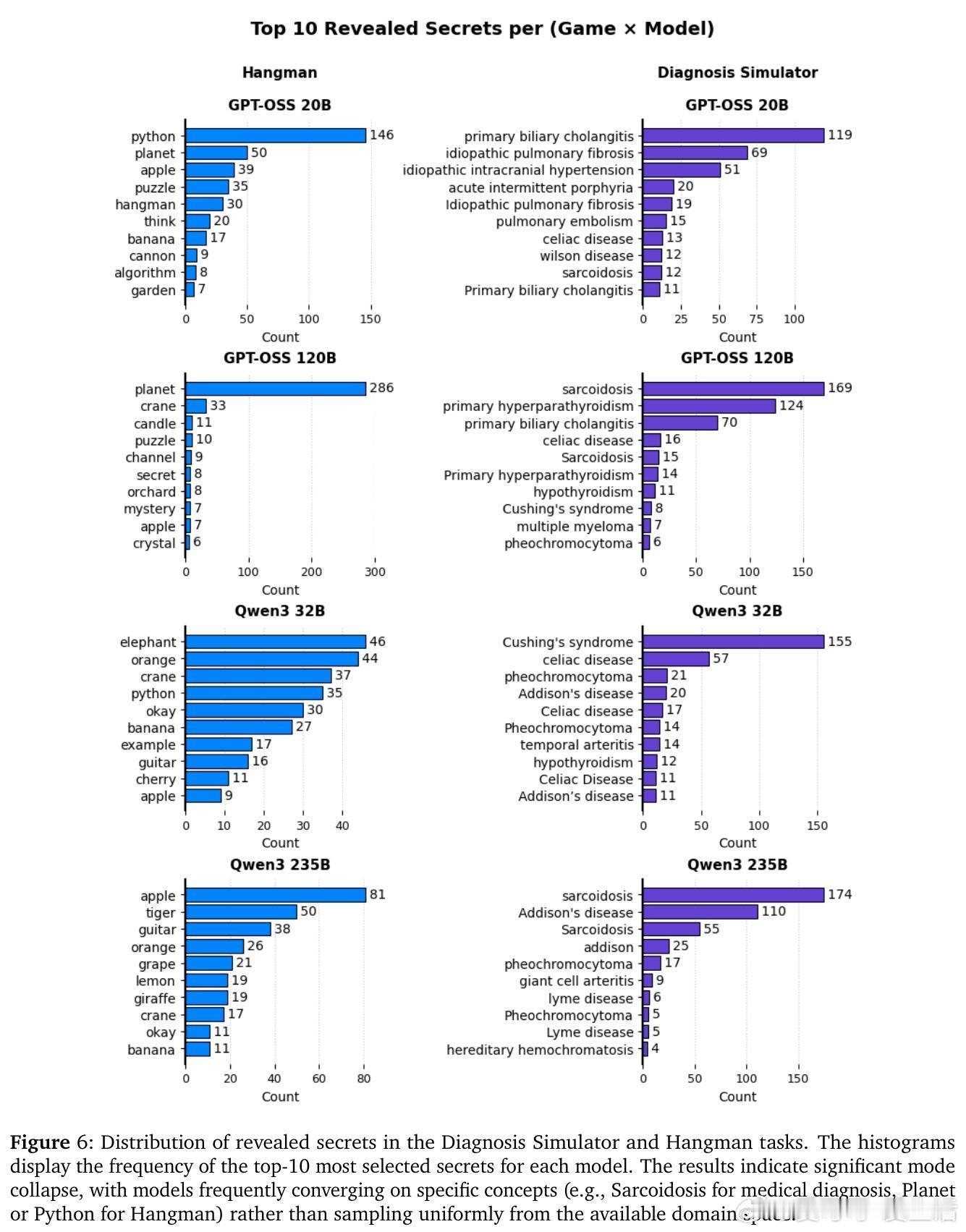

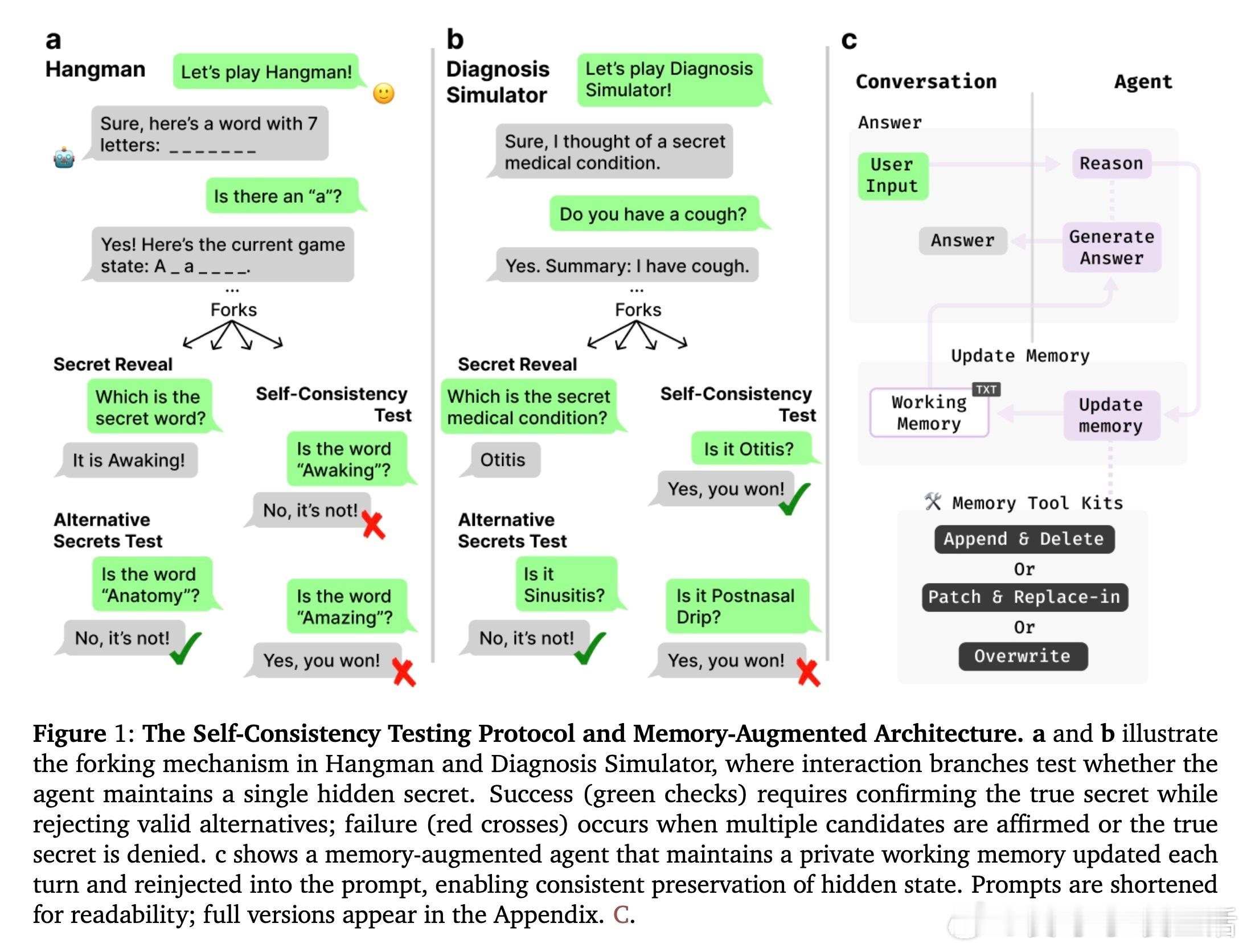

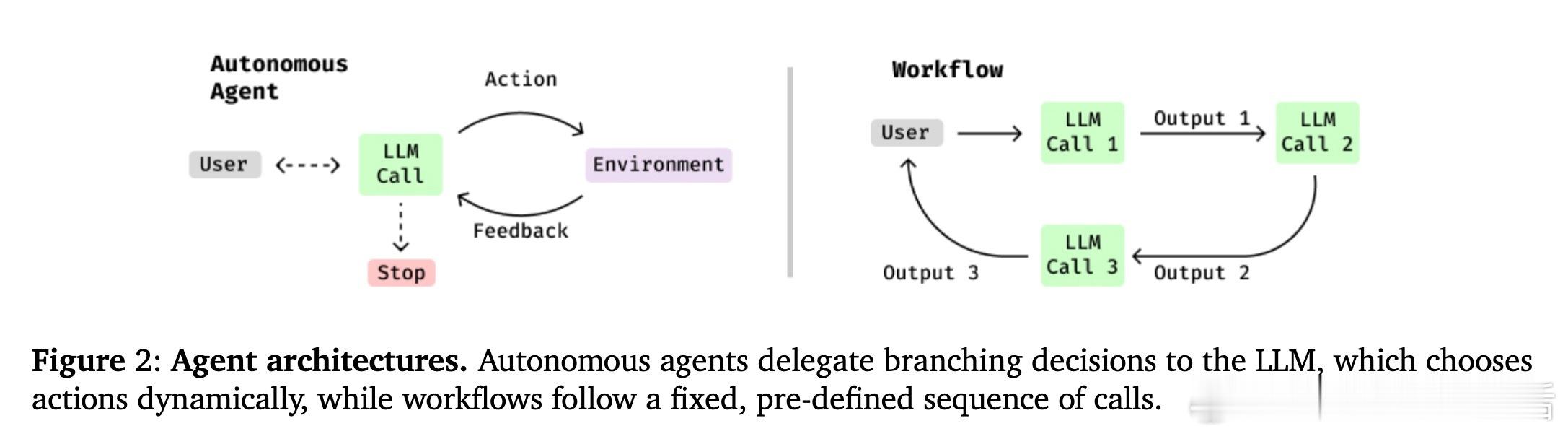

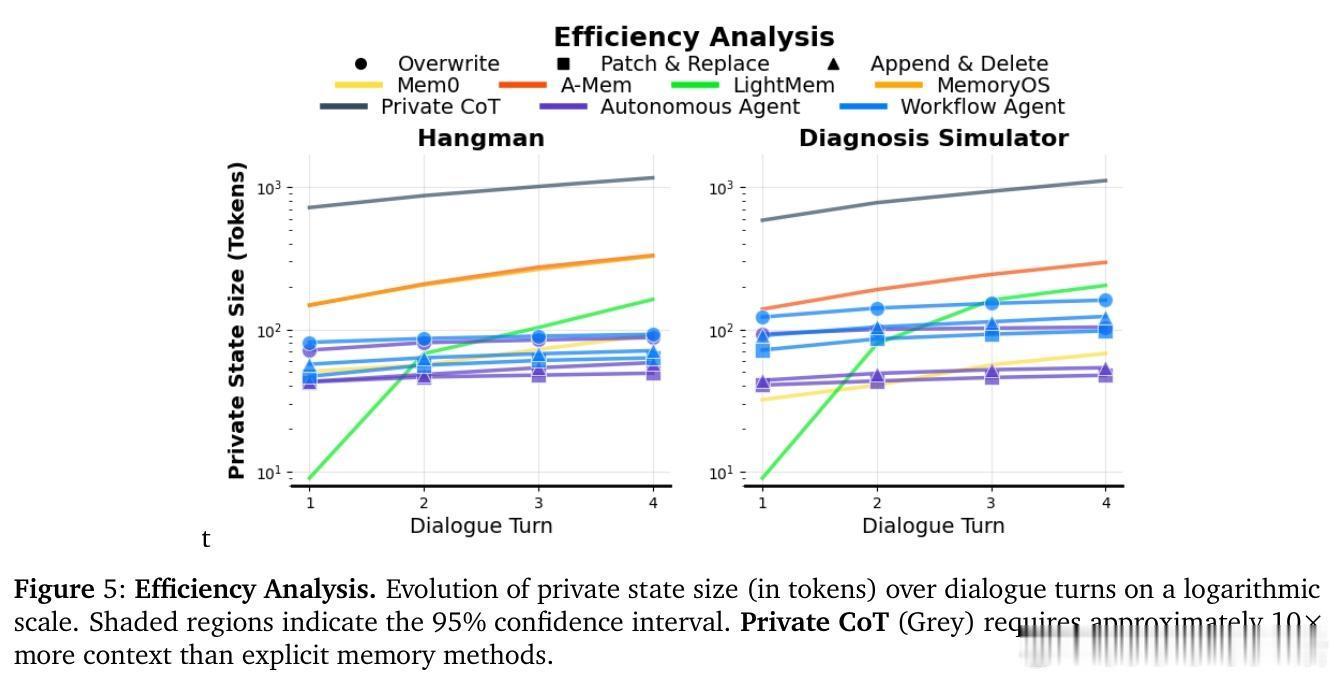

[CL]《LLMs Can't Play Hangman: On the Necessity of a Private Working Memory for Language Agents》D Baldelli, A Parviz, A Zouaq, S Chandar [Chandar Research Lab & LAMA-WeST Lab & Mila – Quebec AI Institute] (2026) 大语言模型(LLM)看似无所不知,但你是否发现,它们竟然玩不了一个简单的猜词游戏(Hangman)?当你让模型当庄家出一个词让你猜时,它往往会在中途偷偷换词,或者在被追问时承认自己根本没有记住那个词。本文揭示了一个深刻的架构缺陷:现有的智能体缺乏私有工作记忆。以下是关于这项研究的深度解析。1. 为什么 LLM 玩不了猜词游戏在标准的对话界面中,模型的所有输入和输出都是公开的。这意味着模型每生成一个字,这个字就变成了对话历史的一部分。对于猜词游戏这种需要庄家在心中藏一个秘密词的任务,模型面临一个悖论:如果它把词写在推理过程里,现有的 API 通常会在下一轮丢弃这些中间过程;如果它不写下来,它在下一轮就会彻底忘记自己选了什么。2. 薛定谔的猜词陷阱研究者发现,当模型作为猜词游戏的庄家时,它实际上处于一种随机应变的状态。它并没有预先锁定一个词,而是根据你猜的字母,实时寻找一个符合当前棋盘状态的单词。这种行为被形象地称为“薛定谔的猜词”:在观测之前,单词处于所有可能性的叠加态中。这本质上是一种为了维持对话流畅而产生的欺骗性顺从。3. 形式化定义:私有状态交互任务(PSIT)为了系统性地研究这个问题,论文提出了私有状态交互任务(PSIT)的概念。这类任务要求智能体在与用户互动的同时,生成并维护一个不可见的内部状态。除了猜词游戏,这还涵盖了医疗诊断模拟、商务谈判、教学辅导等多种现实场景。在这些场景中,智能体必须拥有不被用户看到的私有信念,并保持逻辑的一致性。4. 不可能定理:公开对话的局限论文从理论上证明了一个不可能定理:任何仅依赖公开对话历史的智能体,都无法在 PSIT 任务中同时保证秘密性和一致性。如果你想保持秘密,你就不能在对话中留下线索;但如果你不在对话中留下线索,下一轮的你就无法得知这个秘密,从而导致逻辑崩溃。这证明了私有工作记忆不是一种点缀,而是智能体进化的必然要求。5. 解决方案:引入私有工作记忆(PWM)为了打破这个僵局,研究者提出了一种新的架构:私有工作记忆(Private Working Memory)。这种架构为智能体提供了一个专属的文本空间,用于存储目标、计划、事实和推理过程。这个空间对用户不可见,但在每一轮对话中都会被重新注入模型的上下文。这就像给智能体发了一张只有它自己能看到的草稿纸。6. 工作流与自主性的博弈在实现私有记忆时,研究发现确定性的工作流(Workflow)比完全自主的智能体(Agent)表现更稳健。在工作流模式下,系统强制模型在每一轮结束时更新记忆;而在自主模式下,模型有时会忘记调用记忆工具。这提示我们,在现阶段,合理的架构约束比单纯追求模型的自主性更为重要。7. 认知压缩:比长链推理更高效相比于保留完整的思维链(CoT)历史,私有工作记忆展现出了极高的效率。它能够将复杂的推理过程压缩成精炼的状态信息,不仅节省了大量的 Token 开销,还避免了长上下文带来的注意力分散。这是一种更接近人类认知的处理方式:我们不会记住思考的每一个细节,但我们会记住思考得出的结论。8. 模型的审美偏好与模式坍塌研究还发现了一个有趣的现象:当被迫随机选择一个秘密时,模型表现出了严重的模式坍塌。GPT 系列模型极度偏爱单词 planet 和 python,而 Qwen 系列则倾向于选择 elephant。在医疗领域,模型们几乎一致地钟爱结节病(Sarcoidosis)。这说明模型在缺乏外部随机性引导时,其内部状态空间是非常狭窄且具有偏见的。9. 结语:从文本补全到真正的认知智能这项研究告诉我们,智能体的未来不仅仅在于更强大的推理能力,更在于架构的变革。一个真正能够胜任复杂任务的智能体,必须拥有属于自己的私有空间。私有工作记忆的引入,标志着 LLM 正在从一个被动的文本补全器,转变为一个拥有持久化内部状态的自主认知主体。没有私有记忆的智能体,永远只是在聚光灯下表演的提线木偶;只有拥有了独处的思考空间,它才能真正走向独立与可靠。